GOOGLE ACCESIBILIDAD

Científico con dificultades en el habla crea herramienta para ser entendido

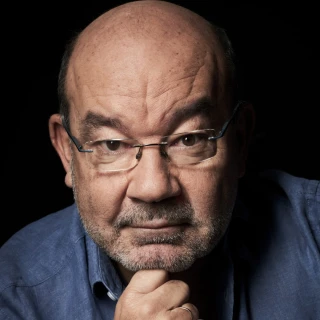

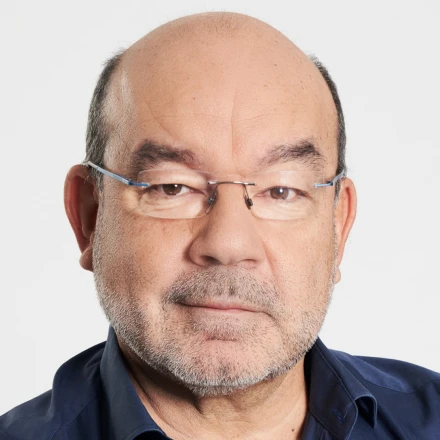

Dimitri Kanevsky, un científico de Google con dificultades en el habla, ha creado una herramienta capaz de transcribir en tiempo real lo que dice, y que funciona gracias al aprendizaje automático y la inteligencia artificial.,Se trata de "Euphonia", un proyecto, aún en desarrollo, que nace con el objetivo de ayudar a las personas a ser entendidas, mejorando así su accesibilidad, y que Kanevsky ha presentado este jueves en las oficinas de Google en Madrid.,El proyecto se ce

Publicado el - Actualizado

3 min lectura

Dimitri Kanevsky, un científico de Google con dificultades en el habla, ha creado una herramienta capaz de transcribir en tiempo real lo que dice, y que funciona gracias al aprendizaje automático y la inteligencia artificial.

Se trata de "Euphonia", un proyecto, aún en desarrollo, que nace con el objetivo de ayudar a las personas a ser entendidas, mejorando así su accesibilidad, y que Kanevsky ha presentado este jueves en las oficinas de Google en Madrid.

El proyecto se centra sobre todo en mejorar el reconocimiento automático de voz y en cómo se puede entrenar a ordenadores y dispositivos móviles para comprender mejor a las personas que tienen dificultad a la hora de pronunciar palabras debido a complicaciones neurológicas por enfermedades o lesiones cerebrales traumáticas.

Y es que, como recuerda este investigador ruso en la página web de este proyecto de Google, para los millones de personas en todo el mundo que tienen dificultades a la hora de hablar, la comunicación cara a cara puede ser un gran desafío.

Aunque hay herramientas como el asistente de Google o Google Home que pueden ayudar a la gente a llamar a alguien o a ajustar la iluminación, es posible que estas no funcionen de manera tan eficaz para aquellas personas con problemas en el habla, señala.

Esto se debe a que los algoritmos de reconocimiento de voz "han visto" millones de ejemplos de personas cuyas voces suenan "típicas" pero pocos de personas con deficiencias en el habla, por eso Kanevsky desarrolló esta herramienta.

Kanevsky pensó en un principio que la investigación no le llevaría más de cinco años, pero al final necesitó muchos más años para desarrollarla.

Ahora esta es capaz de transcribir los mensajes de cualquier persona en tiempo real después de un "entrenamiento" que puede durar unas 25 horas; esto es lo que hizo este investigador, repetir distintas frases durante este tiempo para que la aplicación se acostumbrara y se adaptara a su manera de hablar.

Para seguir implementándola, el científico pide ahora voluntarios, que presten sus voces para continuar con "el entreno" de su sistema y así mejorarlo.

En un futuro, según dijo en la presentación Kanesvsky, la herramienta estará disponible para 70 idiomas.

Reconoce que su sueño era desarrollar un proyecto de reconocimiento de voz que pudiera ayudar a la gente que no oye y/o no puede comunicarse correctamente.

"Ahora tengo una aplicación que me permite entender a otras personas y que estas personas me entiendan a mí para poder dar conferencias sobre geometría algebraica", una de sus vocaciones, subraya Kanevsky: "esto es maravilloso".

Antes de unirse a Google, Dimitri fue miembro del equipo de investigación en el departamento de Algoritmos de Habla y Lenguaje en el Centro de Investigación Watson de IBM; también trabajó en Instituto Max Planck de Alemania o el Instituto de Estudios Avanzados de Princeton.

A la demostración acudieron el deportista en natación adaptada Enhamed Enhamed, quien dijo que es "impensable cómo la tecnología avanza en estos últimos diez años" y define como "radical" la influencia en su caso, "para comunicarse con facilidad".

Alguna de las situaciones cotidianas en las que le favorece la herramienta se da en los aeropuertos: saber la puerta de embarque gracias a la inteligencia artificial sin necesidad de preguntar a nadie.