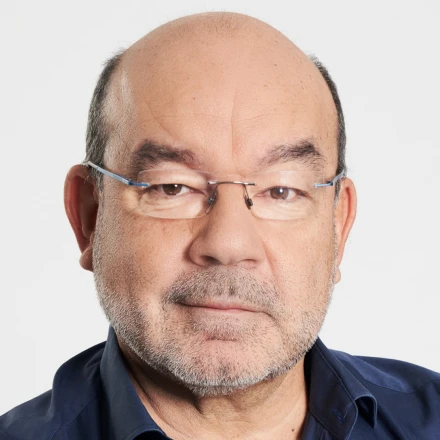

David Ezpeleta: "Muchas personas están reemplazando a la sociedad de carne y hueso por un chatbot conversacional"

El neurólogo y experto en Inteligencia Artificial, analiza y destaca cómo la IA es complaciente y da respuestas correctas como chatbot, al mismo tiempo que es delicada a la hora de tratar problemas personales o de salud

David Ezpeleta analiza el uso de la IA en los jóvenes

Madrid - Publicado el - Actualizado

2 min lectura

En sociedades como las nuestras, donde se extiende una epidemia silenciosa de soledad no deseada, la inteligencia artificial viene a rellenar un hueco afectivo que puede llegar a ser peligroso. David Ezpeleta lo tiene claro: "Estamos tratando problemas personales, incluso de salud y entonces la cosa cambia un poco y es más delicada".

"Si uno mira, por ejemplo, las encuestas de soledad no deseada de la fundación 11, los porcentajes de personas que responden a haberse sentido solo con frecuencia muchas veces en los últimos meses, es mayor en las generaciones más recientes" comenta Ezpeleta.

Cada vez son más las personas que cambian a la sociedad de carne y hueso por un chatbot conversacional con el que entablan una conversación donde cuentan, prácticamente todo sin darse cuenta del riesgo que ello conlleva. Uno de ellos es la antropomorfización. "Pierdes la realidad de que estás hablando realmente con un agente que hace respuestas estadístico-matemáticas y piensas que hay alguien ahí detrás. Y entonces le confiesas todo y vives un mundo paralelo electrónico" asegura.

La sensación de soledad cada vez es más frecuente en los más jóvenes. Toda esta digitalización nos está haciendo más solitarios y más dependientes de la tecnología. Los jóvenes tienen un acceso y manejo mejor este tipo de chatbots, no solamente chat GPT.

Ezpeleta advierte sobre los riesgos de un empleo desmedido de la IA: "Les resuelven tareas del colegio, de la escuela, se le puede preguntar de todo, de forma que es una una irrupción tecnológica, que se está extendiendo como la pólvora y se está haciendo en muchos casos, un uso abusivo incorrecto".

Más allá del uso abusivo en tareas cotidianas, Ezpeleta subraya que estas herramientas no siempre responden a los fines para los que deberían servir. "El problema es la falta de alineamiento de estas inteligencias artificiales con los objetivos y los intereses humanos", concluye.