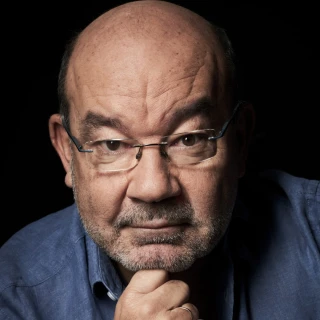

Andrés Visús, experto en IA: "Para recrear un deep fake necesitaríamos 5 minutos de una voz"

La Inteligencia Artificial está empezando a legislarse por las amenazas que el uso de la tecnología puede plantear a la hora de saber si algo es verídico o no.

Andrés Visús, experto en IA: "Para recrear un deep fake necesitaríamos 5 minutos de una voz"

Madrid - Publicado el - Actualizado

2 min lectura

Un Deep Fake es un vídeo en el que se muestran imágenes falsas, habitualmente del rostro de una persona, que parecen ser reales y que se han producido utilizando Inteligencia Artificial. En concreto, técnicas de Machine Learning denominadas Deep Learning, aprendizaje profundo, que utiliza algoritmos de redes neuronales.

La falsificación y alteración de las fotos no es nada nuevo, sin embargo, la Inteligencia Artificial permite no solo alterar imágenes, sino crearlas. Hasta hace unos pocos años, era tan sumamente costoso realizar un intercambio de cara en unos fragmentos de vídeo, que únicamente algunos estudios de cine podían afrontar los cientos de miles o millones de euros que costaba a su departamento de efectos especiales.

Andrés Visús, Director de Desarrollo de Negocio de Inteligencia Artificial en PredictLand, especializado en el ámbito de la Inteligencia Artificial nos contaba en 'Herrera en COPE' lo siguiente: "La inteligencia artificial aprende de los datos, digamos que los modelos aprenden de estas caracteríticas de estos datos, los modelos cuando han aprendido son capacs de reproducirlos". No es magia, es ciencia. Es por esto, que es más sencillo recrear una imagen o sonido de voz de una persona famosa donde haya un exceso de material que pueda crear mapas de aprendizaje.

El problema viene de quien se vale de la Ineligencis Artificial para recrear palabras o prácticas deshonrosas en una persona:"Hay que cuestionar los que no hacen un uso de la IA que no sea ético".

De hecho, se puede utilizar la propia Inteligencia Artificial para detectar Deep Fakes. Compañías como Google han lanzado una base de datos con miles de vídeos manipulados para desarrollar herramientas que detecten las falsificaciones. Cada vez hay una regulación más fuerte a nivel europeo que limita este uso. Se quiere instaurar la firma de imágenes y audios para verificar que tú eres el autor de ese vídeo, en el caso que no seas tú hay una firma digital que lo revela. Esto salvaría a muchos usuarios que han sido víctimas del uso indebido de su imágen pública.